随着市场对化工产品多样化需求的日益提高,间歇生产方式在化工生产过程中的应用比重也不断提高[1, 2]。然而,一方面新产品的生产过程不成熟,可用的数据量少;另一方面产品质量指标难以实时监测,通过实验室分析的离线测量存在严重的滞后,因而如何在数据量不足的情况下建立间歇生产过程质量指标预测模型对于稳定产品质量具有至关重要的作用。

间歇过程产品质量的预测已有较成熟的方法,常见的有偏最小二乘法(Partial Least Square, PLS)、支持向量回归法(Support Vector machine Regression, SVR)等。Nomikos等[3]通过转换三维的间歇过程数据为二维从而建立预测模型。Jiang等[4]提出一种优化的稀疏PLS方法,并应用在青霉素发酵过程与工业注塑工艺中。Luo等[5]结合滑动窗口策略提出了多线性PLS,在原有的数据结构上利用了数据间的内在联系。王普等[6]在大肠杆菌的产品预测提出基于扩展得分矩阵的多阶段间歇过程质量预测方法。这些方法在对过程指标进行预测的时候只关注当前时刻的数据对结果的影响,而忽略了批次与批次之间的潜在联系。实际的间歇生产过程具有慢时变特性,即各个批次之间并不是完全一样地重复生产,设备的老化、反应釜壁腐蚀等一些外在因素随着时间的变化都有可能导致各个批次之间随着某些规律进行变化,直接使用传统的统计学习方法进行预测可能产生一定的偏差,通过捕捉批次与批次之间的规律变化进而挖掘数据之间的时间特征具有更强的现实意义。

神经网络由于其具有较强的非线性映射能力在间歇过程质量预测领域广泛应用。Wang等[7]在间歇过程质量预测领域,使用长短期记忆(Long Short Term Memory, LSTM)网络结合堆叠自编码器的方法,提取数据的深度复杂特征并且对特征进行集成与压缩。Qi等[8]根据间歇过程的高维度等特性提出一种深度自编码器结合双向LSTM网络方法。李泽龙等[9]针对高炉炼铁的大滞后、动态特征建立了LSTM-RNN预测模型。但此类基于神经网络的建模方法通常需要大量训练数据进行支持,对于刚投入生产的间歇过程,由于其生产时间较短,一般不具备足够建模的历史过程生产数据,因而难以建立可靠的预测模型。迁移学习通过学习源域数据的信息,为目标域数据的预测模型提前注入先验知识,用于解决目标域中的小样本问题。Gang等[10]为了解决锂电池性能评估任务中遇到的小样本问题,引入迁移学习的方法结合深度学习提出了一种CNN-LSTM融合模型方法。Ma等[11]在小样本下地铁交通应急客流预测中预测精度低的问题上,将LSTM网络应用于基于迁移学习的方法上。郑真等[12]提出融合迁移学习和LSTM网络对新能源功率进行预测。然而此类基于迁移学习的方法存在一定局限性,如果源域数据和目标域数据之间分布存在较大的差异,将会导致所建立的模型预测精度不高。

领域自适应方法多被用于源域数据和目标域数据之间的特征匹配。Chen等[13]为了解决复杂工况下设备样本数据不足导致剩余使用寿命预测精度低的问题,在预测模型中融合领域自适应方法,有效提高了模型的预测精度以及泛化能力。Fu等[14]提出了一种领域自适应的深度学习融合模型SAE-LSTM,通过减少源域数据和目标域数据之间分布差异进而提高模型预测精度。Li等[15]提出多核最大均值差异(Maximum Mean Discrepancy,MMD)的卷积神经网络模型,在预测效果上取得了较大的提升。Costa等[16]提出了一种基于LSTM和域对抗神经网络的交叉工作条件下剩余使用寿命预测的域自适应方法,该方法很大程度上解决了小样本数据导致的剩余使用寿命预测精度低的问题。间歇过程小样本问题的研究当前多采用数据直接迁移的方法,而2个相似过程存在差异的情况下直接使用迁移策略可能会影响模型预测精度,很少有研究将领域自适应方法应用于间歇过程领域来进一步提高模型预测的精度。另外在间歇生产过程中,变量之间的相关程度大小相差很大,如果能在输入数据之前对不同变量进行权重的分配,可能加快训练过程的收敛速度并且进一步提高精度。

总的来说,小样本下间歇过程质量指标预测存在3个难题,一是因设备的老化、反应釜壁腐蚀等外在因素波动下的模型预测精度问题;二是如何捕捉到批次间的时间依赖信息以及多维建模特征之间的空间相关信息问题;三是在小样本问题下使用迁移学习方法如何克服源域数据和目标域数据之间的分布差异,进一步提高预测模型的精度。针对以上问题,本研究提出一种基于领域自适应的间歇过程质量预测模型方法。首先,由于过程变量和测量指标之间的相关程度相差很大,模型引入空间注意力机制为不同输入变量分配不同权重;使用卷积操作挖掘多维过程变量之间的空间特征以降低冗余信息对模型预测精度的影响;长短期记忆单元则致力于捕获批次与批次之间的时间规律信息。其次,针对质量预测中面临的小样本问题,将迁移学习策略应用于质量预测模型的训练过程中,通过领域自适应的方法实现训练过程中源域数据和目标域数据的特征空间对齐,降低2个数据集因分布差异对预测模型的影响。

1 理论基础 1.1 卷积神经网络卷积神经网络(Convolutional Neural Network, CNN)[17]多用于处理多维度输入矩阵,如应用于性能评估任务中作为多维信息的抽象提取部分。常用的CNN为一维卷积和二维卷积,前者常用于序列数据领域[18],后者则常见于图像处理领域。在本研究中,使用的间歇过程数据为时间序列数据,故使用一维卷积在特征维度方向上进行维度的压缩,提取输入数据特征。

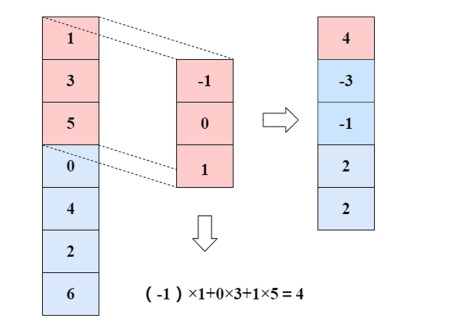

图 1为一维卷积运算示例,其中卷积核大小为3×1,使用该卷积核和被卷积区域对应的数值相乘求和,之后移动该卷积核一个步幅大小,不断重复操作直到遍历完全。计算如(1)所示。

| $ \begin{equation*} y_{j}^{l}=\sum _{i=1}^{M} x_{i}^{l} * k_{i j}^{l}+b_{j}^{l} \end{equation*} $ | (1) |

|

| 图 1 一维卷积运算示例 Fig.1 Example of one-dimensional convolution operation |

| |

式(1)中:yjl表示第l层的第j个卷积运算后结果;*表示卷积符号;M为输入特征向量的个数;bjl为第l层与第i个输入特征向量进行卷积操作的卷积核;bjl为第l层的第j个偏置项。

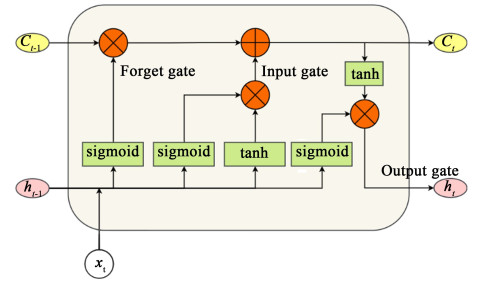

1.2 LSTM递归神经网络(Recurrent Neural Network, RNN)因其具有隐藏状态迭代的特性,在时间序列数据中可以对每个时间步的数据进行信息获取。但是RNN存在梯度消失和爆炸的问题。LSTM网络模型引入遗忘门机制判断需要遗忘的不重要信息与需要记忆的重要信息以此解决梯度消失和梯度爆炸的问题[19]。其结构如图 2所示。

|

| 图 2 LSTM网络单元 Fig.2 LSTM unit |

| |

LSTM单元的计算见式(2)。

| $ \begin{gather*} i_{t}=\sigma_{\mathrm{i}}\left(W_{\mathrm{i}} \cdot\left[h_{t-1} ; x_{t}\right]+b_{\mathrm{i}}\right) \\ f_{t}=\sigma_{\mathrm{f}}\left(W_{\mathrm{f}} \cdot\left[h_{t-1} ; x_{t}\right]+b_{\mathrm{f}}\right) \\ \tilde{c}_{t}=\tanh \left(W_{c} \cdot\left[h_{t-1} ; x_{t}\right]+b_{\mathrm{i}}\right) \\ o_{t}=\sigma_{\mathrm{o}}\left(W_{\mathrm{o}} \cdot\left[h_{t-1} ; x_{t}\right]+b_{\mathrm{o}}\right) \\ c_{t}=f_{t} \odot c_{t-1}+i_{t} \odot \tilde{c}_{t} \\ h_{t}=o_{t} \odot \tanh \left(c_{t}\right) \end{gather*} $ | (2) |

式(2)中:xt、it、ft、ct、ht分别表示t时刻的变量输入、输入门结果、遗忘门结果、细胞状态、细胞输出;Wi、Wf、Wc、Wo分别表示输入门权重矩阵、遗忘门权重矩阵、细胞更新权重矩阵、输出门权重矩阵;σ(·)为是sigmoid激活函数,tanh(·)表示tanh激活函数;bi、bf、bo表示偏差。

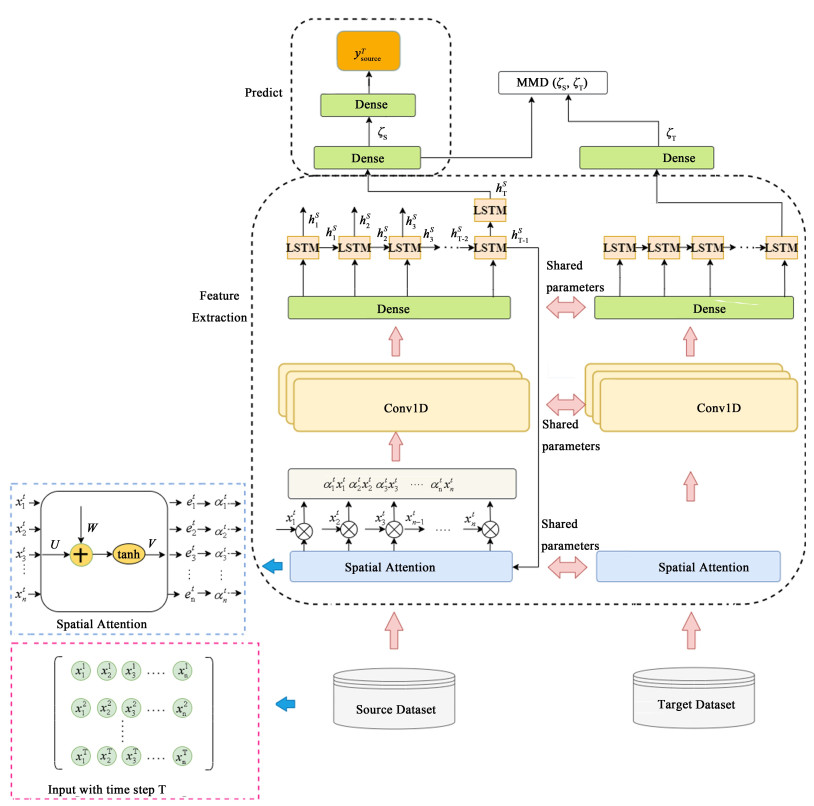

2 DACNN-LSTM模型本研究提出的DACNN-LSTM模型结构如图 3所示。整体可分为特征提取和预测2部分。

|

| 图 3 DACNN-LSTM预训练模型结构图 Fig.3 Structure diagram of DACNN-LSTM pre-training model |

| |

特征提取部分主要采用结合空间注意力机制的多层卷积神经网络与LSTM网络进行特征提取,其原因是间歇生产过程各个过程变量对预测指标的影响程度大小相差很大,在模型中添加空间注意力机制可以为过程变量自适应分配权重。由于间歇过程变量具有高维度特征,使得数据信息存在冗余问题,采用多层一维卷积,经过CNN处理的高维输入初步可提取过程变量之间的空间特征并实现降维。由于间歇过程具有慢时变特性,引入LSTM网络综合考虑每个时刻的历史信息,从而捕获间歇过程不同批次之间在时间上的依赖信息。

预测部分则为2层全连接层,第1层用作MMD测量层,对源域数据和目标域数据的特征进行自适应匹配。第2层是预测结果输出层。

2.1 不同权重分配在间歇生产过程中,过程变量对终点质量指标的贡献程度不一样,故在数据输入时需要对过程变量按照对预测指标的影响程度不同从而分配不同的权重,因此模型中引入了空间注意力机制[20][21]。

第k条输入时间序列

| $ \begin{equation*} h_{t}=f\left[h_{t-1}, o\left(x_{t}\right)\right] \end{equation*} $ | (3) |

式(3)中:ht表示当前时刻LSTM细胞单元的隐藏信息;f(·)代表非线性映射函数;o(·)代表权重分配函数。

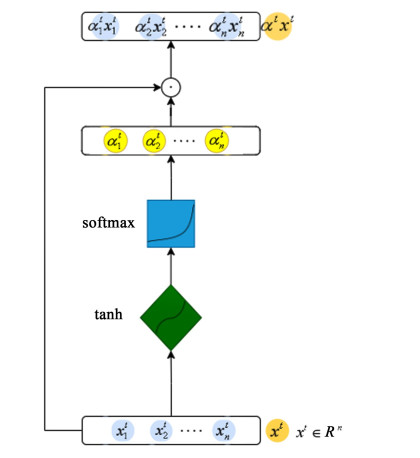

注意力机制实现流程如图 4所示,输入特征变量通过空间注意力机制为不同变量分配不同权重,加权过程的计算见式(4)~(5)。

| $ \begin{gather*} e_{t}^{k}=\boldsymbol{v}_{\mathrm{e}}^{\top} \tanh \left(\boldsymbol{W}_{\mathrm{e}}\left[\boldsymbol{h}_{t-1} ; \boldsymbol{s}_{t-1}\right]+\boldsymbol{U}_{\mathrm{e}} \boldsymbol{x}^{k}\right) \end{gather*} $ | (4) |

| $ \alpha_{t}^{k}=\frac{\exp \left(e_{t}^{k}\right)}{\sum _{i=1}^{n} \exp \left(e_{t}^{i}\right)} $ | (5) |

|

| 图 4 注意力权重分配图 Fig.4 Diagram of attention weight distribution |

| |

式(4)和(5)中:

当采用较少的样本训练1个模型时,为了避免模型的过拟合可以对模型进行约束。迁移学习方法则是先让模型学习相似数据集的规律信息从而得到预训练模型,再通过微调获得目标模型[22]。基于模型的迁移学习方法一般常见于神经网络模型中,使用源域数据对模型进行训练,获得预训练模型之后固定网络结构的某一层或几层,使用目标域数据对未被固定的网络结构进行微调,从而获得预测模型。

领域自适应方法是迁移学习领域中广泛应用于实现目标域数据和源域数据的自适应匹配的方法[23, 24]。主要作用是测量不同数据集之间的差异。MMD作为模型损失函数,在领域自适应中较为常见,其计算如式(6)所示。

| $ \operatorname{MMD}\left(X_{\mathrm{S}}, X_{\mathrm{T}}\right)=\left\|\frac{1}{N_{\mathrm{S}}} \sum_{j=1}^{N_{\mathrm{S}}} \varphi\left(x_j^s\right)-\frac{1}{N_{\mathrm{T}}} \sum_{i=1}^{N_{\mathrm{T}}} \varphi\left(x_i^t\right)\right\| $ | (6) |

式(6)中:φ代表将数据X映射到H再生希尔伯特空间(RKHS);NS是源域数据样本量;NT是目标域样本量;xis和xit表示源域特征和目标域特征;φ(xis)和φ(xit)表示原始空间到RKHS的映射。在实验过程中,为了计算方便,使用MMD平方进行计算,计算过程如式(7)所示。

| $ \operatorname{MMD}^{2}\left(X_{\mathrm{S}}, X_{\mathrm{T}}\right)=\frac{1}{N_{\mathrm{T}}^{2}} \sum\limits_{i=1}^{N_{\mathrm{T}}} \sum\limits_{j=1}^{N_{\mathrm{T}}} \varphi\left(x_{i}\right)^{T} \varphi\left(y_{j}\right)+ \\ \frac{1}{N_{\mathrm{S}}^{2}} \sum\limits_{i=1}^{N_{\mathrm{S}}} \sum\limits_{j=1}^{N_{\mathrm{S}}} \varphi\left(x_{i}\right)^{T} \varphi\left(y_{j}\right)-\frac{2}{N_{\mathrm{S}} N_{\mathrm{T}}} \sum\limits_{i=1}^{N_{\mathrm{T}}} \sum\limits_{j=1}^{N_{\mathrm{S}}} \varphi\left(x_{i}\right)^{T} \varphi\left(y_{j}\right)= \\ \frac{1}{N_{\mathrm{T}}^{2}} \sum _{i=1}^{N_{\mathrm{T}}} \sum _{j=1}^{N_{\mathrm{T}}}\left\langle\varphi\left(x_{i}\right), \varphi\left(y_{j}\right)\right\rangle_{H}+ \\ \frac{1}{N_{\mathrm{S}}^{2}} \sum _{i=1}^{N_{\mathrm{S}}} \sum _{j=1}^{N_{\mathrm{S}}}\left\langle\varphi\left(x_{i}\right), \varphi\left(y_{j}\right)\right\rangle_{H}- \\ \frac{2}{N_{\mathrm{S}} N_{\mathrm{T}}} \sum _{i=1}^{N_{\mathrm{T}}} \sum _{j=1}^{N_{\mathrm{S}}}\left\langle\varphi\left(x_{i}\right), \varphi\left(y_{j}\right)\right\rangle_{H} $ | (7) |

由于RKHS一般来说是高维空间甚至是无限维的空间,为了避免高维复杂操作,通常使用高斯核函数:

| $ \begin{equation*} K(a, b)=\mathrm{e}^{\frac{-\|a-b\|^{2}}{\sigma}} \end{equation*} $ | (8) |

式(8)中:a和b代表不同样本;σ代表函数的宽度参数。

引入核计算:

| $ \begin{equation*} \langle\varphi(x), \varphi(y)\rangle_{H}=K(x, y) \end{equation*} $ | (9) |

故式(7)可简化为式(10)。

| $ \begin{gather*} \mathrm{MMD}^{2}=\frac{1}{N_{\mathrm{T}}^{2}} \sum\limits_{i=1}^{N_{\mathrm{T}}} \sum\limits_{j=1}^{N_{\mathrm{T}}} K\left(x_{i}, y_{j}\right)+\frac{1}{N_{\mathrm{S}}^{2}} \sum\limits_{i=1}^{N_{\mathrm{S}}} \sum\limits_{j=1}^{N_{\mathrm{S}}} K\left(x_{i}, y_{j}\right)- \\ \frac{2}{N_{\mathrm{S}} N_{\mathrm{T}}} \sum\limits_{i=1}^{N_{\mathrm{T}}} \sum\limits_{j=1}^{N_{\mathrm{S}}} K\left(x_{i}, y_{j}\right) \end{gather*} $ | (10) |

在预训练阶段,分别将源域数据和目标域数据作为DACNN-LSTM模型的输入端数据,使用源域数据的标签进行训练。源域数据和目标域数据之间的分布存在差异的情况下,将MMD添加到损失函数以优化目标,实现2个数据集的自适应匹配。预训练网络模型的损失函数定义如式(11)所示。

| $ \begin{equation*} \text { Loss = MSE_loss + } \lambda \text { MMD_loss } \end{equation*} $ | (11) |

式(11)中:λ代表平衡系数,λ>0。

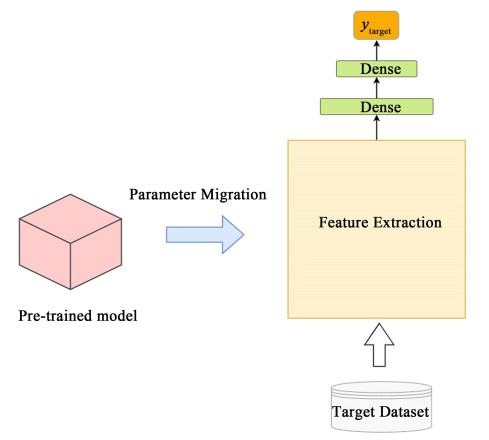

2.3 目标模型的微调虽然在融合模型中添加了领域自适应损失使得预训练模型所学习的信息靠近目标域数据本身具有的规律,但预训练模型难免会学到源域数据集上和目标域数据不同的规律,而这个偏差会随着源域数据占比的增大而增大,故预训练模型需要进行优化。使用目标域数据进行第2次训练,其实质是预训练模型保留一些可继承的参数,对于不可继承的进行微调,以此来提高模型的可靠性。

模型微调过程如图 5所示。整个微调期间使用目标域数据进行训练,使用“冻结机制”来“冻结”特定几层,冻结机制的意义在于在初次训练的网络模型基础上对额外的新数据再训练,不需要从头开始训练网络,这样可以节约大量的时间开销以及计算资源,该机制可以简单地概括为只在模型训练期间的网络模型结构的“冻结”。被“冻结”的结构不参与模型的训练,只训练其他未被“冻结”的部分以此来实现模型的微调。同时保持最后全连接层的不断更新。在本模型中“冻结”特征提取网络结构即空间注意力机制层与多层CNN和LSTM部分,这是因为间歇生产过程的源域数据和目标域数据虽然个体数据可能差异很大,但是总体的数据集变化趋势是相似的,故保留特征提取部分,优化预测部分。

|

| 图 5 微调过程 Fig.5 Fine-tuning process |

| |

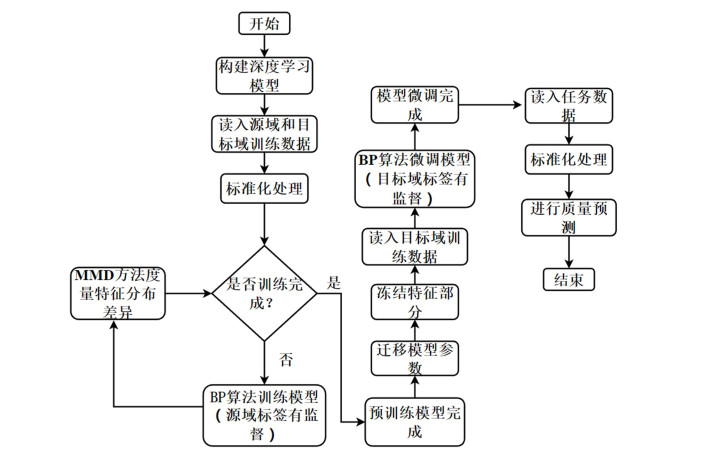

基于DACNN-LSTM质量预测算法包括预训练模型、模型的微调优化和预测3个过程。其算法流程如图 6所示,具体步骤如下:(1) 由于间歇过程变量之间量纲不同,需要在输入网络模型之前对数据进行标准化处理。(2) 预训练网络模型:确定模型的结构,初始化网络参数。源域数据和目标域数据分别为XS与XT,其格式为N ·T ·D,其中N为批次大小;T为时间步长;D为特征维度。利用源域数据及其标签按照反向传播算法有监督地训练模型,并不断计算特征分布差异修正网络参数。(3)模型微调:将预训练模型迁移到目标任务模型,并使用目标域数据的训练集及其标签按照反向传播算法有监督地训练该目标任务模型,训练期间冻结特征提取部分,只对预测部分进行训练学习,达到模型的微调优化目的。(4)使用微调后的模型计算网络输出,得到质量预测结果。

|

| 图 6 算法流程 Fig.6 Algorithm flow |

| |

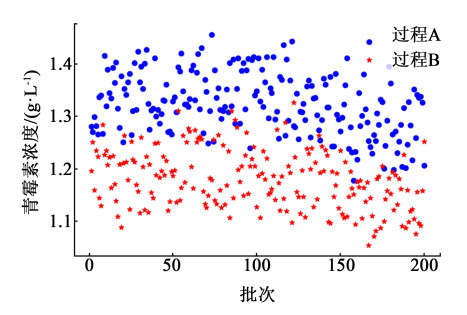

青霉素作为一种在临床应用广泛的抗生素类产品,其生产过程是一种典型的间歇工业过程。作为青霉素生产模型,Pensim仿真平台已经通过了相关研究的验证。本研究使用Pensim 2.0仿真软件生成青霉素仿真数据[25]。Pensim 2.0生成的数据批次与批次之间是完全一致重复生产的,但实际间歇过程具有慢时变特性,各批次之间存在随时间变化的潜在规律。数据生成时对原始模型加入了时间的影响,用来代表如反应釜腐蚀等产生的对于反应速率的影响。过程反应周期和采样间隔时间设置为400 h和0.5 h,过程变量包含底物浓度、搅拌功率、底物进料温度等14个过程变量。首先对这些数据进行一次终点时刻数据提取,得到模型的输入变量分别为XS与XT。按照表 1设置的工作条件生成过程数据,过程A为旧过程,过程B作为刚投入运行的新过程。各采集200批次的青霉素仿真数据,其终点质量分布如图 7所示,可以看出给的输入变量操作条件不同,所得到的2个过程的青霉素终点质量分布也是不同的。

| 输入变量 | 过程A的数值范围 | 过程B的数值范围 |

| 通风率/(L·h-1) | 6~7 | 5~6 |

| 搅拌功率/W | 35~44 | 32~41 |

| 底物进料温度/K | 296.3~298.2 | 298.5~297.3 |

| 培养体积/L | 108~113 | 105~109 |

| pH值 | 4.1~4.6 | 4.3~5.2 |

| CO2浓度/(mmol·L-1) | 0.62~0.65 | 0.52~0.56 |

| pH值设定点 | 5.1~5.3 | 5.0~5.2 |

|

| 图 7 青霉素生产过程A和B的终点浓度 Fig.7 End point concentrations of penicillin production processes A and B |

| |

针对具体多少数据量才是小样本的这一问题,一直以来都没有明确的定义。针对这一问题,用不同批次数据进行实验,使用LSTM和CNN-LSTM预测模型来确定在本实验中小样本数据量的界定。首先,采集2 000批次的过程B数据,划分该数据为2 000批、1 500批、1 000批、500批、200批5个数据集S1,S2,S3,S4和S5。实验结果如表 2所示,其中S1和S2准确率基本相等,S2,S3,S4准确率变化不大,S4的准确率和S5的准确率相差很大,所以当样本数量为200时,模型预测精度具有明显的降低。故在本研究中,标记200个样本量为小样本,500个及以上数量的样本为大量样本。

| Data Set | LSTM | CNN-LSTM | |||||

| RMSE | MAE | MAPE | RMSE | MAE | MAPE | ||

| S1 | 0.019 8 | 0.015 5 | 1.311 3 | 0.017 5 | 0.014 3 | 1.223 0 | |

| S2 | 0.019 2 | 0.015 4 | 1.301 1 | 0.018 3 | 0.014 3 | 1.220 1 | |

| S3 | 0.022 6 | 0.017 8 | 1.508 5 | 0.023 8 | 0.019 3 | 1.671 1 | |

| S4 | 0.024 7 | 0.019 2 | 1.642 7 | 0.023 6 | 0.019 7 | 1.687 6 | |

| S5 | 0.048 1 | 0.040 5 | 3.456 3 | 0.036 6 | 0.030 9 | 2.714 0 | |

因此本实验中分别采集500个批次过程A数据作为源域数据XS500×14,200个批次过程B数据作为目标域数据XT200×14。

3.1.2 数据预处理考虑到各个变量之间的数值差异较大,避免各个变量量纲对模型预测结果的影响,实验时需要对数据进行归一化处理,其计算如式(12)所示。

| $ \begin{equation*} x_{i, j}^{\mathrm{norm}}=\frac{x_{i, j}-x_{j}^{\min }}{x_{j}^{\max _{j}^{\min }} \forall i, j} \end{equation*} $ | (12) |

式(12)中:xi, j是原始输入数据中第j个特征变量的第i个数据;xjmax和xjmin分别是第j个特征变量的最大值和最小值;xi, jnorm是归一化后的结果。

3.1.3 性能分析指标与参数设置为了分析模型的性能,需要选择性能指标对实验结果进行评估。采用RMSE、MAE、MAPE性能分析指标判断预测模型的性能,可以从不同侧面衡量真实值和预测值之间的误差,其值越小说明误差越小,模型准确度越高。

本研究网络模型是基于Python3.6和torch深度学习框架搭建的。目标域数据划分70%数据量为训练集,30%为测试集。实验中时间步长设为8,各个对比模型对间歇过程数据的输入格式在时间维度上要求不同,故选择测试集60个批次中后53个批次数据进行展示。选择2层CNN,隐藏单元数分别为16,32。LSTM网络隐藏层神经单元数为32。全连接层神经单元数分别为32和16。采用Adam优化器对网络进行训练,epoch统一设置为120代,batch_size为16,实验结果为多次试验取平均。

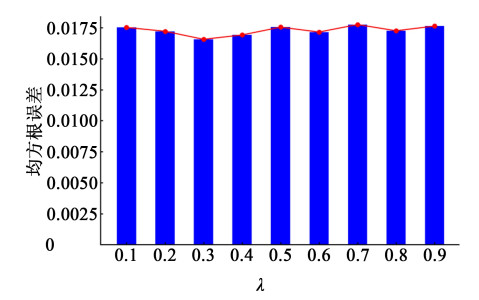

3.1.4 实验结果与分析MMD损失的平衡系数λ对数据集的自适应匹配效果影响较大,直接影响了模型的预测精度,故需要对λ进行选择。通过调节不同比例的λ进行实验,结果如图 8所示,横轴是λ值,纵轴是RMSE模型评估性能指标。当λ=0.3时,RMSE达到最小值,本实验中MMD_loss的平衡系数λ选择为0.3。

|

| 图 8 MMD损失不同比例结果对比 Fig.8 Comparison of results of different proportions of MMD loss |

| |

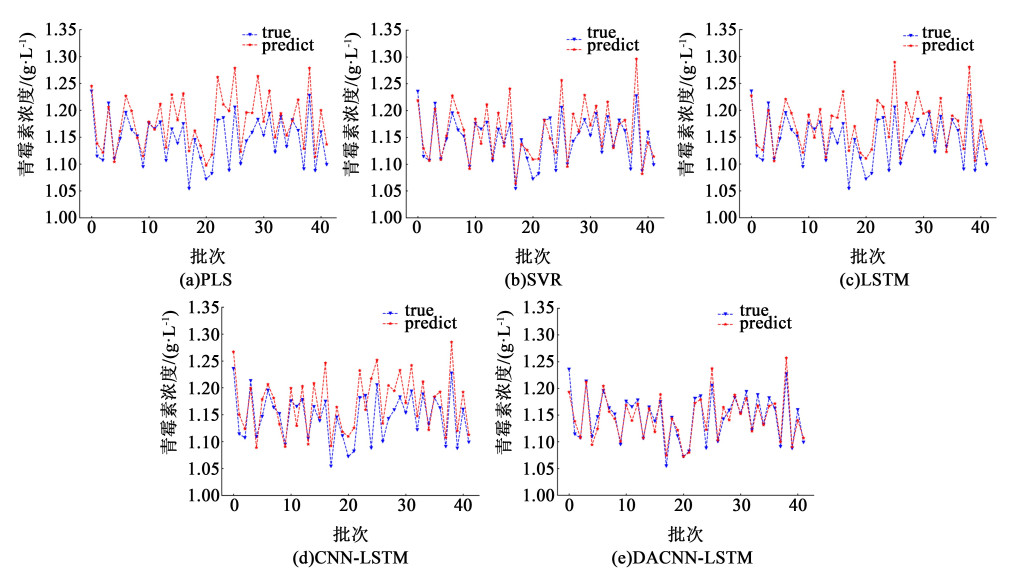

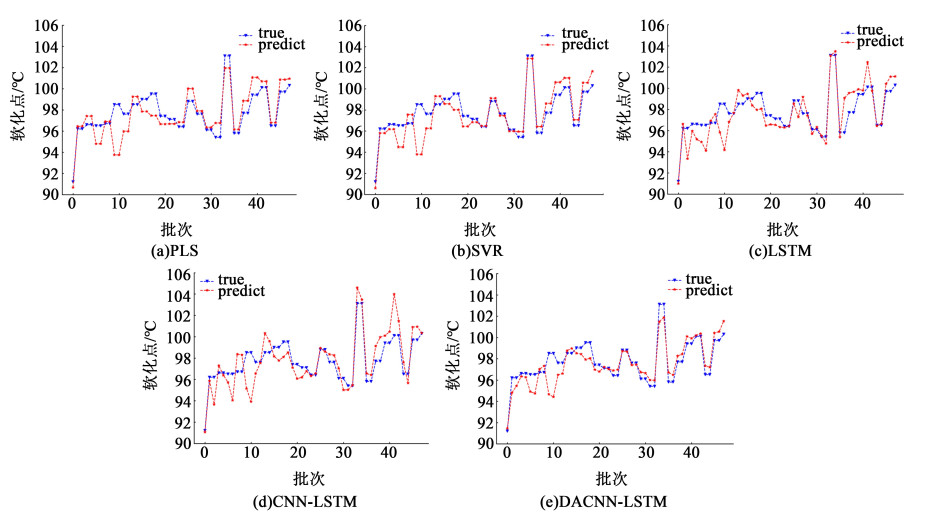

使用间歇过程终点质量指标预测中常用的方法与本模型的预测结果进行比较,分别为PLS、SVR、LSTM、CNN-LSTM。图 9显示了各个模型的预测结果和实际结果的拟合曲线,表 3则是各个模型性能指标具体数值(加粗部分表示最优指标)。从PLS预测结果图来看,预测曲线和真实曲线拟合不理想,具有较大偏差。LSTM模型和CNN-LSTM模型相较于PLS回归方法曲线拟合更好,体现了模型中添加的特征挖掘能力以及非线性处理能力使得模型准确性进一步提高,但由于数据量太少,并不能得到可靠的模型。SVR在小样本下在表现上进一步提升,体现了在本实验中该模型选取的小样本数据中具有一部分有效的支持向量,在小样本数据下甚至具有比一般神经网络的效果好的结果,但仍具有较大偏差。DACNN-LSTM模型从结果上来看,预测值与真实值拟合的更好。

|

| 图 9 不同模型预测结果对比 Fig.9 Comparison of prediction results of different models |

| |

| Model | RMSE | MAE | MAPE |

| PLS | 0.040 7 | 0.033 6 | 2.943 2 |

| SVR | 0.027 5 | 0.021 4 | 1.850 1 |

| LSTM | 0.034 2 | 0.028 5 | 2.494 1 |

| CNN-LSTM | 0.037 4 | 0.030 4 | 2.650 7 |

| DACNN-LSTM | 0.016 6 | 0.012 6 | 1.087 2 |

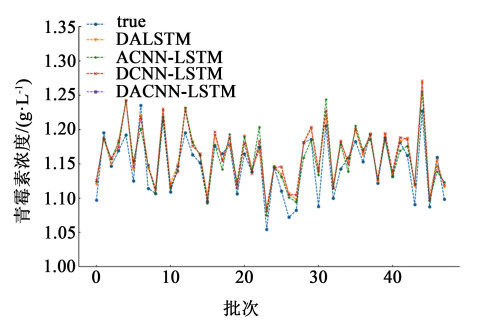

为了分析模型结构的合理性以及各部分组件对模型预测精度的提高的帮助,对DACNN-LSTM模型进行消融实验。分别对未带有CNN结构的DALSTM,未带有领域自适应的ACNN-LSTM,未带有空间注意力机制的DCNN-LSTM以及初始模型DACNN-LSTM进行实验对比。表 4以及图 10结果表明,DACNN-LSTM和实际数据拟合的更好,具有更小的误差。进一步对该结果分析得到,未带有CNN网络模型的DALSTM与DACNN-LSTM模型相比,特征提取能力方面有所减弱,无法降低高维度特征的冗余信息从而影响模型的预测精度。DACNN-LSTM和未带有MMD自适应匹配损失的ACNN-LSTM模型相比,加入MMD损失帮助模型提高了预测精度,说明在预训练过程中,为了防止学习源域数据特征带来的偏差过大,加入MMD损失使得预训练过程中不断修正模型参数,实现了源域数据和目标域数据的自适应对齐,从而在预测精度上面实现了进一步的提升。带有空间注意力机制的DACNN-LSTM模型与没有该部分的模型进行对比,在拟合程度上,拥有注意力机制更加贴合实际结果,从准确度具体数值上来看加入空间注意力机制预测误差有所减小。体现了一些过程变量对青霉素浓度的生成起到关键作用而有些过程变量对青霉素浓度的生成起到辅助作用,在实验时过程变量的输入不该一视同仁,需要分配不同的权重。

| Model | RMSE | MAE | MAPE |

| DALSTM | 0.020 5 | 0.016 0 | 1.407 5 |

| ACNN-LSTM | 0.021 9 | 0.017 9 | 1.563 5 |

| DCNN-LSTM | 0.021 7 | 0.017 4 | 1.522 9 |

| DACNN-LSTM | 0.016 6 | 0.012 6 | 1.087 2 |

|

| 图 10 青霉素生产过程浓度模型消融实验结果图 Fig.10 Ablation experiment results of Penicillin production process concentration model |

| |

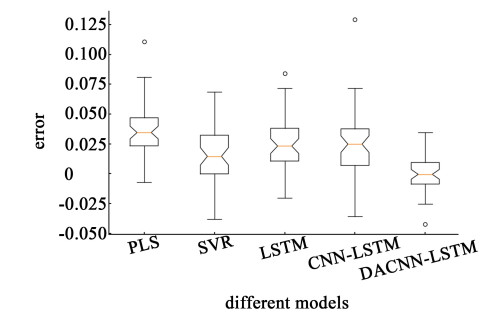

为了进一步比较模型预测结果的稳定性以及准确性,对不同算法的预测误差结果进行分析。从图 11的结果可以看出,基于数据驱动的PLS、LSTM、CNN-LSTM算法因为样本量少,所训练出来的模型准确度不高,误差波动范围较大,模型较为不稳定。SVR方法训练的模型误差的平均值相较于上述算法进一步提升,但误差波动范围较大,模型同样不稳定。可明显看到DACNN-LSTM模型的测量值和真实值之间的误差平均值均好于其他算法模型,误差箱型图上下四分位数也是处于最优结果,并且该模型预测结果误差的波动范围较小,故该模型在稳定性以及预测精度方面均有较大提高。

|

| 图 11 不同模型的误差四分位图 Fig.11 Error quartile map of different models |

| |

酚醛树脂是一种常见的化工原材料,其被广泛应用于耐火材料、摩擦材料等产品中,其生产过程是一个典型的多阶段间歇生产过程,酚醛树脂有软化点、色度等质量指标需要符合质量要求,产品不同其质量指标不同。在本实验中,使用生产酚醛树脂生产过程现场真实数据进行实验,对酚醛树脂的软化点进行预测。工厂主要生产2种酚醛树脂,酚醛树脂产品的生产周期很长,其中产品A可以采集到数据500个批次,产品B可采集到数据200批次,由于数据量的限制,无法使用3.1.1节中分批次实验的方法确定酚醛树脂中的小样本数据量。但对产品B的软化点直接预测时经过多次试验,均得不到好的预测效果。故使用产品A作为源域数据,帮助解决产品B得不到好的预测结果的问题。

选取6个关键过程变量分别是醛类的质量、喂料速率、液态醛类质量、醛类占比、反应总时间、真空度,得到模型的源域数据和目标域数据分别为XS500×6与XT200×6,目标域数据划分70%数据量为训练集,30%为测试集。为了避免各变量的量纲对模型预测结果的影响,使用3.1.2节中归一化方法对输入变量进行处理。实验中将时间步长设为8。选择2层CNN,隐藏单元数分别为16,32。LSTM网络隐藏层神经单元数为32。全连接层神经单元数分别为32,16。采用Adam优化器对网络进行训练,epoch统一设置为100代,batch_size为16,实验结果为多次试验取平均。MMD损失的平衡系数λ采用3.1.4节中测量方法,最终选择为0.4。

3.2.2 实验结果与分析表 5、图 12显示了在酚醛树脂软化点预测上,传统的统计学习PLS方法和SVR方法在本实验中,面对小样本数量的数据和真实数据拟合程度有较大的偏差,而LSTM和CNN-LSTM神经网络模型在预测软化点时因为数据量太少所训练的模型泛化能力弱,结果上来看二者所预测结果相比PLS和SVR方法模型较为不稳定,表现上更为糟糕。而本文模型DACNN-LSTM在跟随效果上表现和真实数据拟合效果更好。在RMSE、MAE、MAPE评价指标上本研究所提方法相较于其他方法均有明显提高。

| Model | RMSE | MAE | MAPE |

| PLS | 1.428 8 | 1.098 6 | 1.122 3 |

| SVR | 1.237 6 | 0.899 9 | 0.918 5 |

| LSTM | 1.363 2 | 0.986 6 | 1.008 6 |

| CNN-LSTM | 1.457 3 | 1.091 8 | 1.112 9 |

| DACNN-LSTM | 1.135 1 | 0.813 0 | 0.828 9 |

|

| 图 12 各模型酚醛树脂软化点预测结果对比 Fig.12 Comparison of phenolic resin softening points prediction results of different models |

| |

分别对本研究模型中未带有CNN的DALSTM、未带有领域自适应的ACNN-LSTM、未带有空间注意力机制的DCNN-LSTM与DACNN-LSTM进行对比。表 6和图 13显示了和真实值的跟随效果DACNN-LSTM预测结果表现最好。从各性能指标具体数值来看,本研究所提模型对酚醛树脂软化点的预测更加准确。

| Model | RMSE | MAE | MAPE |

| DALSTM | 1.285 6 | 0.893 8 | 0.911 2 |

| ACNN-LSTM | 1.247 3 | 0.992 2 | 1.013 0 |

| DCNN-LSTM | 1.259 9 | 0.912 0 | 0.931 7 |

| DACNN-LSTM | 1.135 1 | 0.813 0 | 0.828 9 |

|

| 图 13 酚醛树脂产品质量模型消融实验结果图 Fig.13 Results of ablation experiments for phenolic resin product quality model |

| |

针对间歇生产过程中因样本量不足而导致无法对产品终点质量进行准确预测的问题,融合领域自适应与深度学习方法搭建了DACNN-LSTM网络模型。在青霉素生产过程仿真数据集上进行实验,首先使用分批次实验的方法对小样本数量进行了界定,而后和常用的间歇过程终点质量指标预测方法相比,DACNN-LSTM对原始真实数据有更好的拟合效果并且在RMSE、MAE、MAPE性能指标上均有明显的提高。最后对DACNN-LSTM模型各内部结构进行了消融实验以及对模型的稳定性进行了比较,实验结果表明DACNN-LSTM各内部结构具有合理性并且模型稳定性高。为了验证DACNN-LSTM在现场实际数据上的表现,使用酚醛树脂生产过程现场真实数据进行实验。实验结果同样表明本文所提出的模型方法在小样本下有效提高预测模型的精度。

| [1] |

梁秀霞, 庞荣荣, 郭鹭, 等. 基于AMWPSO-LSTM的多阶段间歇过程故障预测[J]. 北京化工大学学报(自然科学版), 2022, 49(2): 116-124. LIANG Xiuxia, PANG Rongrong, GUO Lu, et al. Multi-stage intermittent process fault prediction based on AMWPSO-LSTM[J]. Journal of Beijing University of Chemical Technology (Natural Science Edition), 2022, 49(2): 116-124. (in Chinese) |

| [2] |

纪成, 顾俊发, 王健红, 等. 基于长短时记忆神经网络和支持向量数据描述的间歇过程监测方法[J]. 化学工业与工程, 2022, 39(2): 32-36. JI Cheng, GU Junfa, WANG Jianhong, et al. A batch process monitoring method based on long short term memory network and support vector data description[J]. Chemical Industry and Engineering, 2022, 39(2): 32-36. (in Chinese) |

| [3] |

NOMIKOS P, MACGREGOR J F. Multi-way partial least squares in monitoring batch processes[J]. Chemometrics and Intelligent Laboratory Systems, 1995, 30(1): 97-108. DOI:10.1016/0169-7439(95)00043-7 |

| [4] |

JIANG Q, YAN X, YI H, et al. Data-driven batch-end quality modeling and monitoring based on optimized sparse partial least squares[J]. IEEE Transactions on Industrial Electronics, 2020, 67(5): 4098-4107. DOI:10.1109/TIE.2019.2922941 |

| [5] |

LUO L, BAO S, MAO J, et al. Quality prediction and quality-relevant monitoring with multilinear PLS for batch processes[J]. Chemometrics and Intelligent Laboratory Systems, 2016, 150: 9-22. DOI:10.1016/j.chemolab.2015.11.004 |

| [6] |

王普, 曹彩霞, 高学金, 等. 基于扩展得分矩阵的多阶段间歇过程质量预测[J]. 高校化学工程学报, 2019, 33(3): 664-671. WANG Pu, CAO Caixia, GAO Xuejin, et al. Quality prediction of multistage batch processes based on extended score matrices[J]. Journal of Chemical Engineering of Chinese Universities, 2019, 33(3): 664-671. DOI:10.3969/j.issn.1003-9015.2019.03.021 (in Chinese) |

| [7] |

WANG K, GOPALUNI R B, CHEN J, et al. Deep learning of complex batch process data and its application on quality prediction[J]. IEEE Transactions on Industrial Informatics, 2020, 16(12): 7233-7242. DOI:10.1109/TII.2018.2880968 |

| [8] |

QI J, LUO N. Using stacked auto-encoder and Bi-directional LSTM for batch process quality prediction[J]. Journal of Chemical Engineering of Japan, 2021, 54(4): 144-151. DOI:10.1252/jcej.19we235 |

| [9] |

李泽龙, 杨春节, 刘文辉, 等. 基于LSTM-RNN模型的铁水硅含量预测[J]. 化工学报, 2018, 69(3): 992-997. LI Zelong, YANG Chunjie, LIU Wenhui, et al. Research on hot metal Si-content prediction based on LSTM-RNN[J]. CIESC Journal, 2018, 69(3): 992-997. (in Chinese) |

| [10] |

ZOU G, YAN Z, ZHANG C, et al. Transfer learning with CNN-LSTM model for capacity prediction of lithium-ion batteries under small sample[J]. Journal of Physics: Conference Series, 2022, 2258(1): 012042. DOI:10.1088/1742-6596/2258/1/012042 |

| [11] |

MA J, ZENG X, XUE X, et al. Metro emergency passenger flow prediction on transfer learning and LSTM model[J]. Applied Sciences, 2022, 12(3): 1644. DOI:10.3390/app12031644 |

| [12] |

郑真, 朱峰, 马小丽, 等. 基于TL-LSTM的新能源功率短期预测[J]. 综合智慧能源, 2023(1): 41-48. ZHENG Zhen, ZHU Feng, MA Xiaoli, et al. Short-term new energy power prediction based on TL-LSTM[J]. Integrated Intelligent Energy, 2023(1): 41-48. DOI:10.3969/j.issn.2097-0706.2023.01.005 (in Chinese) |

| [13] |

CHEN W, CHEN W, LIU H, et al. A RUL prediction method of small sample equipment based on DCNN-BiLSTM and domain adaptation[J]. Mathematics, 2022, 10(7): 1022. DOI:10.3390/math10071022 |

| [14] |

FU B, WU Z, GUO J. Remaining useful life prediction under multiple operation conditions based on domain adaptive sparse auto-encoder[C]//2020 IEEE International Conference on Prognostics and Health Management (ICPHM). Detroit, MI, USA. IEEE, 2020

|

| [15] |

LI X, ZHANG W, DING Q, et al. Multi-Layer domain adaptation method for rolling bearing fault diagnosis[J]. Signal Processing, 2019, 157: 180-197. DOI:10.1016/j.sigpro.2018.12.005 |

| [16] |

DE OLIVEIRA DA COSTA P R, AKÇAY A, ZHANG Y Q, et al. Remaining useful lifetime prediction via deep domain adaptation[J]. Reliability Engineering & System Safety, 2020, 195: 106682. |

| [17] |

LIU J, ZHOU Z, HE X, et al. Winter wheat yield estimation method based on NDWI and convolutional neural network[J]. Transactions of the Chinese Society for Agricultural Machinery, 2021, 52(12): 273-280. DOI:10.6041/j.issn.1000-1298.2021.12.029 |

| [18] |

ZHAO J, MAO X, CHEN L. Speech emotion recognition using deep 1D & 2D CNN LSTM networks[J]. Biomedical Signal Processing and Control, 2019, 47: 312-323. DOI:10.1016/j.bspc.2018.08.035 |

| [19] |

冯勇, 冯述放, 罗娜. 基于时钟触发长短期记忆的多元时序预测[J]. 华东理工大学学报(自然科学版), 2023, 49(2): 255-268. FENG Yong, FENG Shufang, LUO Na. Multivariate time series prediction based on clockwork triggered long short term memory[J]. Journal of East China University of Science and Technology, 2023, 49(2): 255-268. (in Chinese) |

| [20] |

YUAN X, LI L, SHARDT Y A W, et al. Deep learning with spatiotemporal attention-based LSTM for industrial soft sensor model development[J]. IEEE Transactions on Industrial Electronics, 2021, 68(5): 4404-4414. DOI:10.1109/TIE.2020.2984443 |

| [21] |

DING Y, ZHU Y, FENG J, et al. Interpretable spatio-temporal attention LSTM model for flood forecasting[J]. Neurocomputing, 2020, 403: 348-359. DOI:10.1016/j.neucom.2020.04.110 |

| [22] |

GUPTA J, PATHAK S, KUMAR G. Deep learning (CNN) and transfer learning: A review[J]. Journal of Physics: Conference Series, 2022, 2273(1): 012029. DOI:10.1088/1742-6596/2273/1/012029 |

| [23] |

成于思, 施云涛. 基于深度学习和迁移学习的领域自适应中文分词[J]. 中文信息学报, 2019, 33(9): 9-16, 23. CHENG Yusi, SHI Yuntao. Domain adaption of Chinese word segmentation based on deep learning and transfer learning[J]. Journal of Chinese Information Processing, 2019, 33(9): 9-16, 23. DOI:10.3969/j.issn.1003-0077.2019.09.002 (in Chinese) |

| [24] |

ZHOU Q, ZHOU W, WANG S, et al. Multiple adversarial networks for unsupervised domain adaptation[J]. Knowledge-Based Systems, 2021, 212: 106606. DOI:10.1016/j.knosys.2020.106606 |

| [25] |

褚菲, 彭闯, 贾润达, 等. 基于多尺度核JYMKPLS迁移模型的间歇过程产品质量的在线预测方法[J]. 化工学报, 2021, 72(4): 2178-2189. CHU Fei, PENG Chuang, JIA Runda, et al. Online prediction method of batch process product quality based on multi-scale kernel JYMKPLS transfer model[J]. CIESC Journal, 2021, 72(4): 2178-2189. (in Chinese) |

2024, Vol. 41

2024, Vol. 41